Avant toute chose, il est important de préciser à nouveau que cet article est écrit sans intention de porter un jugement de valeur. L'objectif de cet article reste le même : tenter humblement de permettre au plus grand nombre de comprendre les enjeux, les techniques et les perspectives d'une technologie qui fait appel à de très hauts niveaux de compétence en mathématiques et en informatique.

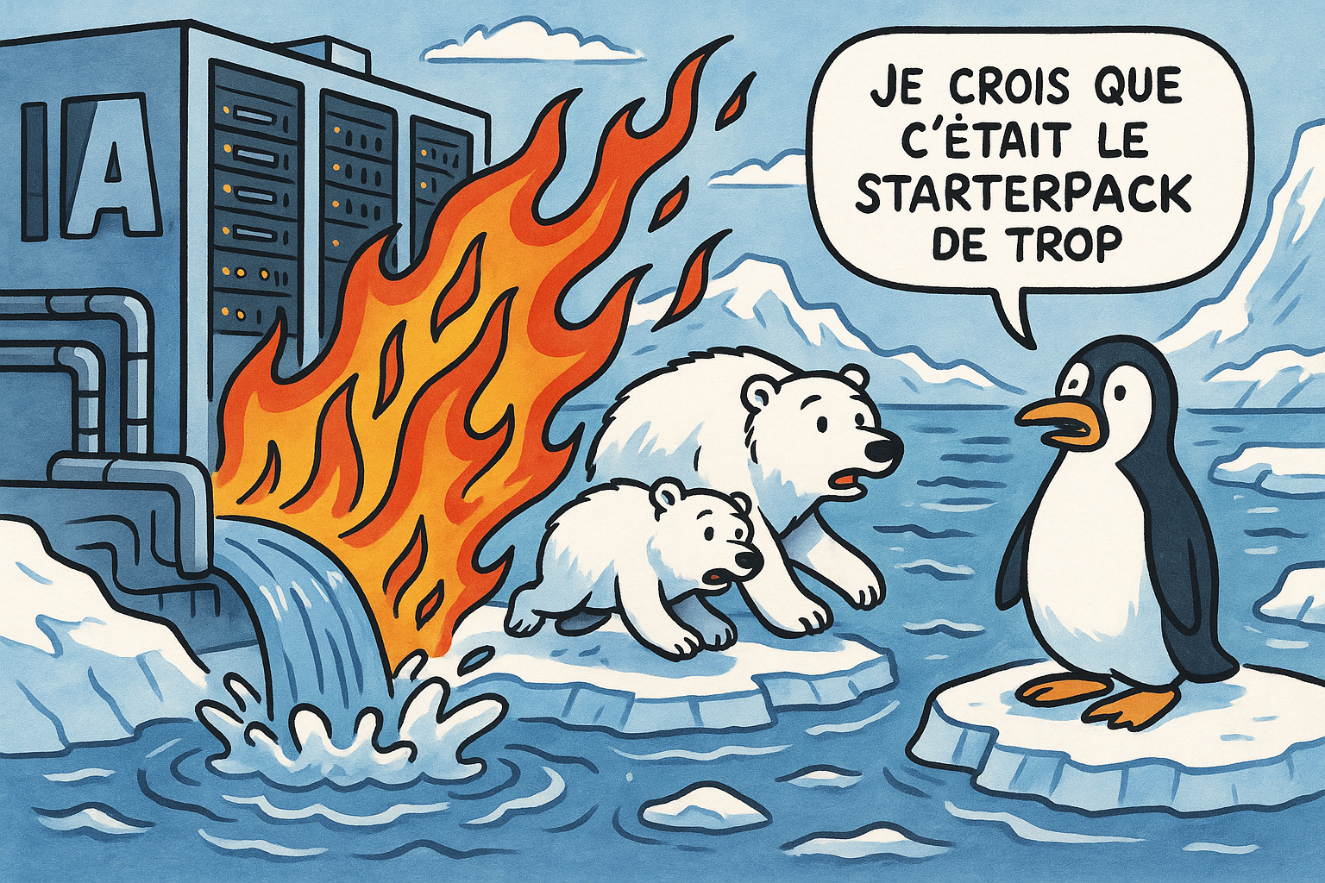

Ces dernières semaines, nous avons vu fleurir sur les réseaux sociaux la mode des "Starter-packs". Nombreux sont ceux qui ont pu représenter leur image accompagnée d'objets de leur quotidien définissant au mieux leur personnalité. Pour bien comprendre d'où vient cette mode, cela est souvent lié à une évolution technologique de l'IA. En effet, ChatGPT a abandonné son modèle de génération d'images par l'IA (DALL-E) au profit d'un modèle directement intégré dans GPT-4. Cette mise à jour de ChatGPT a permis un réel bond technologique et permet désormais de générer des images contenant du texte sans fautes, sans mots inventés, et dans la langue désirée.

Cette vague de génération d'images humoristiques, réalisées par des millions de personnes, est-elle réellement sans conséquence ? Nous avons vu apparaître, en même temps que ces posts, des appels à la sobriété dans l'utilisation de l'IA.

Dans cet article, je tenterai de vous éclairer sur les enjeux environnementaux autour de l'intelligence artificielle, et de l'impact de son utilisation par le grand public grâce à l'accès aux plateformes d'IA générative gratuite.

Afin de cerner le sujet, nous devons parler de la nécessité pour les réseaux neuronaux d'effectuer les mêmes opérations mathématiques (multiplications de matrices, calculs d’algèbre linéaire) sur de très grands ensembles de données. Vous avez probablement déjà voulu acheter un ordinateur ou un téléphone, et vous avez certainement entendu parler de la mémoire vive (RAM), du processeur (CPU) et de la carte graphique. L’intelligence artificielle, plus précisément le machine learning, fait appel à des capacités que seuls les GPU (processeurs des cartes graphiques) sont à même de combler. Les CPU (processeurs principaux des ordinateurs) ne sont pas optimisés pour cela. Il est à noter qu'en moyenne, les GPU consomment jusqu'à 4 fois plus d'énergie à puissance de calcul équivalente que les CPU.

Taillé pour un besoin différent :

Architecture plus adaptée

Essayons désormais de répondre à une question qui vous taraude sûrement jour et nuit depuis que vous avez entendu parler d'IA :

"Que se passe-t-il une fois ma question posée à mon moteur d'IA générative ?"

Vos prompts sont "acheminés", traités et analysés dans des data centers qui peuvent se trouver à différents endroits, selon d'où vous effectuez votre requête. Et un data center ressemble à ça :

Des milliers d'ordinateurs montés en série dans des fermes pouvant atteindre plusieurs hectares. Si l'on prend le cas de l'IA générative française "Mistral", ses serveurs sont installés sur le site de Bruyères-le-Châtel (Essonne), dont la puissance électrique est de 40 mégawatts.

Or, qui dit consommation d'énergie dit production thermique. C'est ce que l'on appelle l'effet Joule. Chaque composant électronique (processeur, mémoire, alimentation, etc.) dissipe de l’énergie sous forme de chaleur lorsqu’il fonctionne.

Outre la consommation énergétique des data centers, leur refroidissement n'est pas avare en ressources.

La méthode la plus répandue repose sur l’utilisation de planchers surélevés et d’unités CRAC (Computer Room Air Conditioner) ou CRAH (Computer Room Air Handler).

Les systèmes de refroidissement, qu'ils soient à air conditionné ou par refroidissement liquide, utilisent de l'eau en grande quantité.

De nombreuses études universitaires ont tenté de quantifier l'impact environnemental de l'IA générative. Pour cet article, je me suis appuyé sur deux d’entre elles :

Voici qui représentation de l'utilisation de l'eau dans le cycle d'apprentissage et d'utilisation de l'IA :

Il faut néanmoins prendre en compte que le mix énergétique utilisé par le pays dans lequel vous effectuez une requête influe grandement sur son impact.

Ainsi, selon cette étude, avec 500 ml d'eau en Irlande, nous pouvons effectuer en moyenne 70 requêtes, alors qu'à Mexico, ce n'est possible que pour 20 requêtes.

Nous avons vu comment et pourquoi l'utilisation de l'IA n'est pas sans impact sur notre environnement. Vous pensez peut-être, et à raison, que rien n'est sans impact. Mais nous, acteurs de la sécurité civile, quelle doit être notre ligne de conduite ? Invoquer l'état de nécessité ? Restreindre ou contraindre l'utilisation de l'IA générative dans nos services ? Ou bien simplement faire appel à la sobriété volontaire dans l'utilisation d'outils surpuissants qui ont peut-être une vocation autre que de suivre les effets de mode ?

Une chose est certaine, l'IA est et sera incontournable dans les services d'incendie et de secours de demain, tant les enjeux de traitement des données, toujours plus nombreuses, sont importants. Le volume d'informations généré par les logiciels métiers à traiter progresse de manière exponentielle, alors que les moyens à disposition progressent au mieux linéairement selon l'inflation.

Nous, acteurs de la sécurité civile, devons en saisir les enjeux et les travers, même ceux qui pourraient nous déranger. C'est le secret d'une utilisation juste et éclairée des possibilités que nous offre l'innovation.

Ltn Ernest Werenfrid

https://www.linkedin.com/in/ernest-werenfrid-6014b7158/

.