Il est désormais bien établi, pour la majorité d’entre nous, que les données, leur qualité et leur gestion représentent un enjeu stratégique majeur pour les Services d’Incendie et de Secours (SIS).

Nos outils et applications métiers génèrent un volume important de données qui ne sont pas toujours exploitées ni exploitables.

La multiplication des supports, la création de tableurs non normalisés, et l’absence de solutions applicatives adaptées contraignent souvent les agents de terrain à bricoler des systèmes d'information parallèles.

Il en résulte une donnée dispersée, hétérogène, parfois mal structurée, ce qui complique son usage à des fins d’analyse ou d’entraînement d’une intelligence artificielle.

Pourtant, dans les serveurs des SIS, la donnée brute nécessaire à l’apprentissage d’une IA existe en théorie.

Mais en pratique, elle nécessite de passer par plusieurs étapes : sélection, formatage, nettoyage, avant même d’envisager son utilisation opérationnelle.

Un SIS souhaitant se lancer dans un projet d’intelligence artificielle doit donc préalablement mettre en œuvre une politique de gouvernance de la donnée.

Contrairement à une idée répandue, en intelligence artificielle — et notamment en machine learning — la qualité des données prime largement sur leur quantité.

Dans cet article, nous allons explorer ce qui se cache derrière la conversion des données en un savoir exploitable par une intelligence artificielle, à travers un exemple concret inspiré de l’étude des feux de forêt.

Quelles sont les étapes de la transformation de données en savoir ?

La plupart des intelligences artificielles utilisent des modèles mathématiques fondés sur la statistique et les probabilités pour apprendre et raisonner.

L’enjeu consiste à convertir une donnée réelle, physique, palpable, en paramètres, fonctions et résultats exploitables permettant d’identifier des corrélations ou des régularités.

En agissant sur différents paramètres d’entrée, l’objectif est d’optimiser le taux de vrais positifs, c’est-à-dire la capacité du modèle à détecter correctement les cas pertinents.

C’est ce que l’on appelle le rappel (recall)

Pour y parvenir, la sélection des données d’entraînement est cruciale : elle doit notamment exclure les données aberrantes, qui sont considérées comme des anomalies statistiques susceptibles de fausser l’apprentissage.

Passer des données brutes à un savoir permettant de décider nécessite plusieurs étapes clés, à la fois techniques et méthodiques.

Je vous propose de les étudier à travers un exemple concret : l’analyse des conséquences d’un feu de forêt.

Dans cet exemple, nous partons de données brutes issues de précédents feux de forêt, notés F1, F2, ..., Fn.

Chaque feu est associé à plusieurs paramètres : température lors de l’éclosion, vent sur zone, humidité, topographie, niveau d’activité opérationnelle au moment du départ, etc.

La première étape consiste à sélectionner, nettoyer et mettre en forme les données pour les contextualiser et les relier entre elles.

Dans un tableau clair, j’extrais ces données, je les mets en forme, puis j’associe à chaque jeu de paramètres la surface effectivement brûlée.

Par exemple : le feu F1 a parcouru 50 hectares.

Maintenant que les données sont exploitables, nous pouvons les analyser d’un point de vue statistique et mathématique : tendances, corrélations, distributions.

À ce stade, l’information devient une connaissance structurée.

Enfin, la dernière étape consiste à formuler des règles logiques ou des modèles adaptés au type d’intelligence artificielle que l’on souhaite intégrer (modèles prédictifs, systèmes experts, réseaux de neurones).

Cela permettra d’analyser de nouvelles données et d’agir en conséquence, de manière automatisée ou assistée.

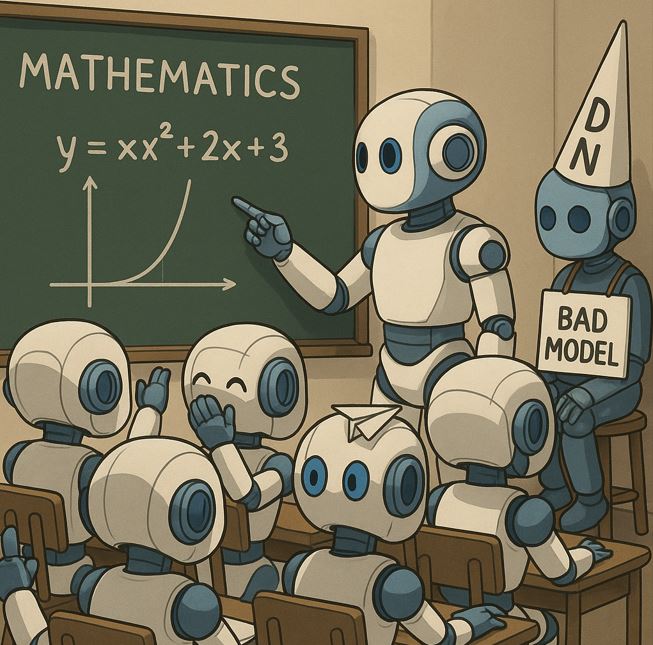

Comme souvent, rien de tel qu'un bon schéma pour comprendre :

Quelles sont les processus techniques de l'apprentissage d'une IA adaptés à l’environnement de mon établissement ?

La problématique des IA grand public, ce sont leurs données d'entraînement qui ont pour objectif de synthétiser la connaissance humaine. Mais lorsque l'on veut obtenir des réponses spécifique, l'IA aura souvent tendance à halluciner. Si vous avez pour projet de créer une IA entraînée spécifiquement avec vos données internes, vous devez vous attendre à entendre plusieurs termes techniques.

À cet effet, voici un glossaire non exhaustif :

Pipeline

Un pipeline est une séquence d'opérations automatisées qui traite les données de bout en bout, de l’ingestion (extraction des données) à leur transformation, modélisation, et exploitation finale (ex : prédictions, visualisation ou API).

Corpus d'entraînement

Base de données textuelle ou structurée contenant les exemples sur lesquels l'IA va s'entraîner. Il doit être pertinent, cohérent et représentatif.

Un corpus peut être constitué de rapports, de dialogues, de procédures, etc.

Tokenisation

Transformation d’un texte en unités de base appelées tokens (mots, sous-mots, caractères), qui seront ensuite converties en nombres.

“pompiers” → [345, 892]

Modèle de langage

IA conçue pour comprendre, générer ou transformer du texte à partir de statistiques apprises sur de grands corpus.

Ex.: GPT, DeepSeek, Mistral, LLaMA...

Entraînement (training)

Processus par lequel l’IA ajuste ses millions à milliards de paramètres internes pour améliorer ses prédictions à partir des données.

Elle apprend à deviner le mot suivant ou à répondre à des questions.

Époch

Un passage complet sur l’ensemble du corpus. Plus il y a d’époques, plus l’IA revoit ses données, mais au risque de surapprendre (overfitting).

Loss (fonction de perte)

Indicateur numérique de l'erreur entre la réponse de l'IA et la bonne réponse. L’objectif de l’apprentissage est de minimiser cette perte.

Fine-tuning

Entraînement complémentaire d’un modèle déjà existant sur un corpus spécifique pour l’adapter à un contexte ou un métier donné.

Ex. : adapter un modèle généraliste pour qu’il comprenne les procédures de sécurité incendie.

Inférence

Phase où le modèle déjà entraîné est utilisé pour générer des réponses à de nouvelles questions ou demandes.

C’est le moment où l’IA “parle” ou “agit” à partir de ce qu’elle a appris.

Prenons l'exemple d'une structure qui souhaiterait disposer de son propre agent virtuel pouvant répondre à des questions spécifiques à un groupement opération :

On veut que l’IA soit capable ensuite de répondre à : Quelles sont les premières étapes lors d’un accident de la route ?

Étapes types :

Note de service, règlement opérationnel, GDO, ...

Extraction des données et mise en forme un un fichier qui peut-être un Json

{

"prompt": "Quelles sont les premières étapes lors d’un accident de la route ?",

"completion": "1. Sécuriser la zone. 2. Établir un périmètre de sécurité."

}

"1. Sécuriser la zone." → [1543, 432, 7821, ...]

À chaque phrase :

Cela se répète des milliers de fois, ligne par ligne, batch par batch.

Ainsi, nous avons vu de manière simplifier ce qui se cache entre vos données et leurs utilisations si vous avez un projet d'IA. Nous avons donc seulement toucher du doigt la complexité et la rigueur nécessaire. Exploiter l’intelligence artificielle dans un environnement opérationnel comme celui des SIS ne relève pas uniquement de la technologie, mais avant tout d’une maîtrise de la donnée : qualité, structuration, accessibilité, gouvernance.

Transformer des données en savoir, ce n’est pas automatiser. C’est structurer, contextualiser, et formaliser l’expérience terrain.

Cela demande du temps, de la méthode, et une collaboration étroite entre les agents métiers, les spécialistes des données, architectes, ingénieur et les développeurs.

Ltn Ernest Werenfrid

https://www.linkedin.com/in/ernest-werenfrid-6014b7158/

.